在本文中,我们将探讨如何使用PyTorch搭建高效的神经网络并实现性能优化。PyTorch是一个开源的机器学习库,广泛用于计算机视觉和自然语言处理,被研究人员和开发者用于加速AI项目的开发。接下来,我们将逐步介绍搭建过程,并着重介绍性能优化的各个方面。

1. 神经网络的搭建

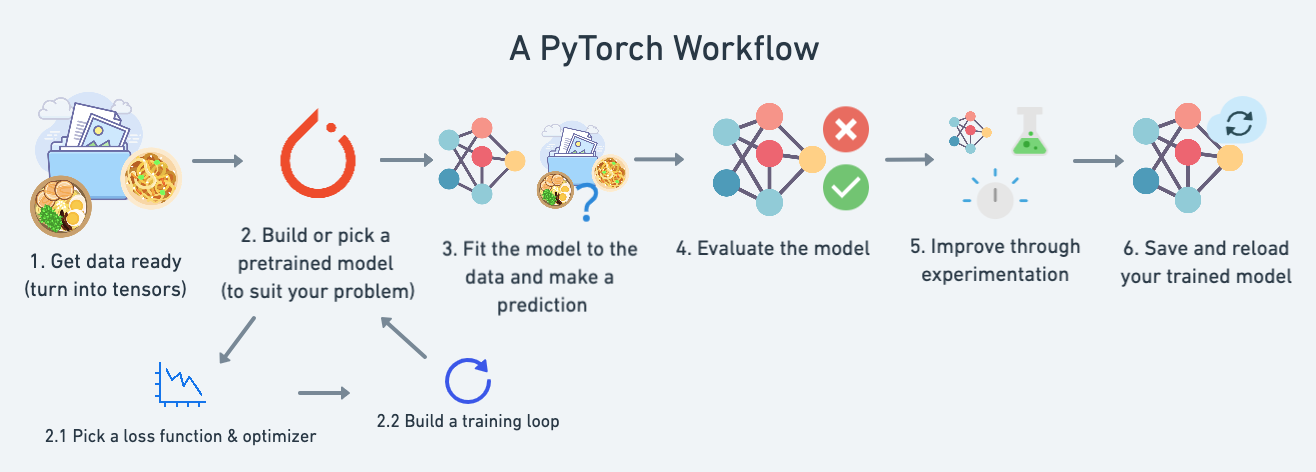

搭建一个高效的神经网络首先需要定义网络结构。PyTorch提供了灵活的模块化设计,允许用户快速构建复杂的网络。下面是搭建一个简单神经网络的基本步骤:

- 定义网络结构:使用

torch.nn.Module创建一个类,定义网络中的层和前向传播方法。 - 初始化模型参数:为网络中的每一层初始化参数,这一步骤对模型学习效率影响巨大。

- 选择优化器和损失函数:根据问题选择合适的优化器和损失函数,这对模型训练至关重要。

接下来的图片展示了搭建神经网络所涉及的关键步骤:

由此图可见,网络的结构直接决定了模型的性能和它能处理的问题类型。

2. 性能优化技巧

数据预处理

优秀的数据预处理可以大大加快模型训练速度,减少过拟合的风险。常用的预处理包括归一化输入数据、数据增强等。

图中展示了数据预处理的常见流程,归一化和数据增强是提升模型泛化能力、加速训练的关键步骤。

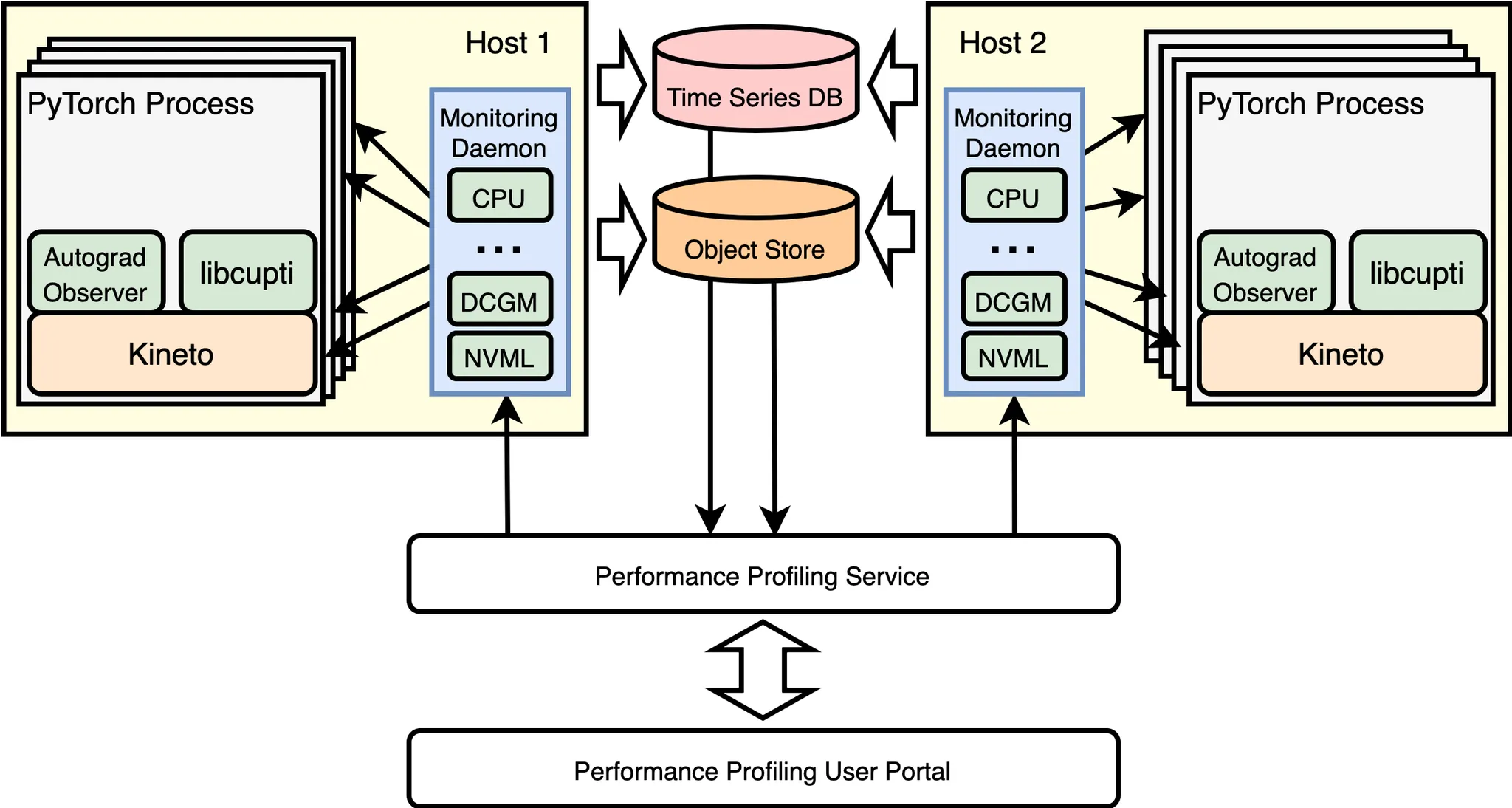

使用GPU加速

PyTorch支持GPU加速,这对计算密集型的神经网络训练非常有帮助。只需简单的代码修改,就可以将计算任务从CPU迁移到GPU上。

此图强调了使用GPU进行加速的优势,GPU能大幅度提升训练和推理的速度。

模型微调与正则化

继承预训练的模型并在此基础上进行微调,是另一种提升神经网络性能的方法。同时,应用正则化技术如Dropout、L2正则化可以减少过拟合,提高模型的泛化能力。

图示了模型微调和正则化应用的示例,这些技巧对提升模型的稳定性和准确性起到了关键作用。

结论

通过使用PyTorch搭建高效的神经网络并实现性能优化,我们可以针对各种复杂的任务设计出更精确、更快速的AI模型。从数据预处理到模型训练,再到使用GPU加速和模型优化,每一步都是提升性能的关键。希望本文能帮助你在未来的项目中灵活运用PyTorch,充分利用其强大的功能来解决实际问题。